【Microsoft Azure】AI Foundry を活用してお手軽エージェントを作ってみる Part1

こんにちは、MS開発部の渋谷です。

昨今AIエージェントという言葉が広まりつつありますが、エージェントの試作やPoCどまりになっていることはありませんか?

最近、生成AIのプロトタイプを作るのは、驚くほど簡単になりました。しかし、多くの企業が「さあ、これを本格的に使おう!」と思った瞬間に、大きな壁にぶつかります。それが「本番環境への展開」です。あちこちのサービスをその場しのぎでつなぎ合わせるような「手作り」の開発スタイルでは、企業の厳しい要求(例えば、たくさんの人が同時に使えるか、会社のルールを守れるか、セキュリティは万全か)をクリアするのは至難の業です。

この大きな課題に対する答えの1つが Azure AI Foundry です。そのゴールは、アイデアが生まれてから、実際にみんなが使えるようになり、その後も安定して動き続けるまで、AIアプリの一生をすべて一つの場所で面倒見ることです。モデル、ツール、データ、そして会社のルール(ガバナンス)を全部まとめて、チームが安全に、そして大規模にAIアプリを作って、展開して、管理できるように設計されています。

この記事(Part1)では、AI Foundryの概要とその立ち位置について解説します。またPart2では、AI FoundryをつかってAIエージェントを作成する方法について解説する予定です。

AI Foundry とは

Azure AI Foundryの根底にある設計思想は「統合」です。これは、かつてのAzure AI StudioやAzure OpenAI Studioといった複数のツールを一つのプラットフォームに統合し、進化させたものです。具体的には次のような機能があります。

- 統合されたリソース管理:エージェント、モデル、ツールといったAI開発に不可欠なコンポーネントを、単一の管理グループ下に集約。これにより、プロジェクト全体の可視性が向上し、リソースの管理が大幅に簡素化されます。

- ビルトインのエンタープライズ機能:本番運用に不可欠なトレース、監視、評価、そしてカスタマイズ可能なエンタープライズセットアップ構成といった機能が標準で組み込まれています。これにより、開発の初期段階から、セキュリティ、パフォーマンス、信頼性を確保したアプリケーション構築が可能となります。

- 統一されたガバナンスモデル:プラットフォームは単一のAzureリソースプロバイダー名前空間の下で提供されます。これにより、統一されたロールベースのアクセス制御(RBAC)、ネットワークポリシー、ガバナンスポリシーの適用が容易になり、組織全体のセキュリティ基準とコンプライアンス要件を一貫して満たすことができます。

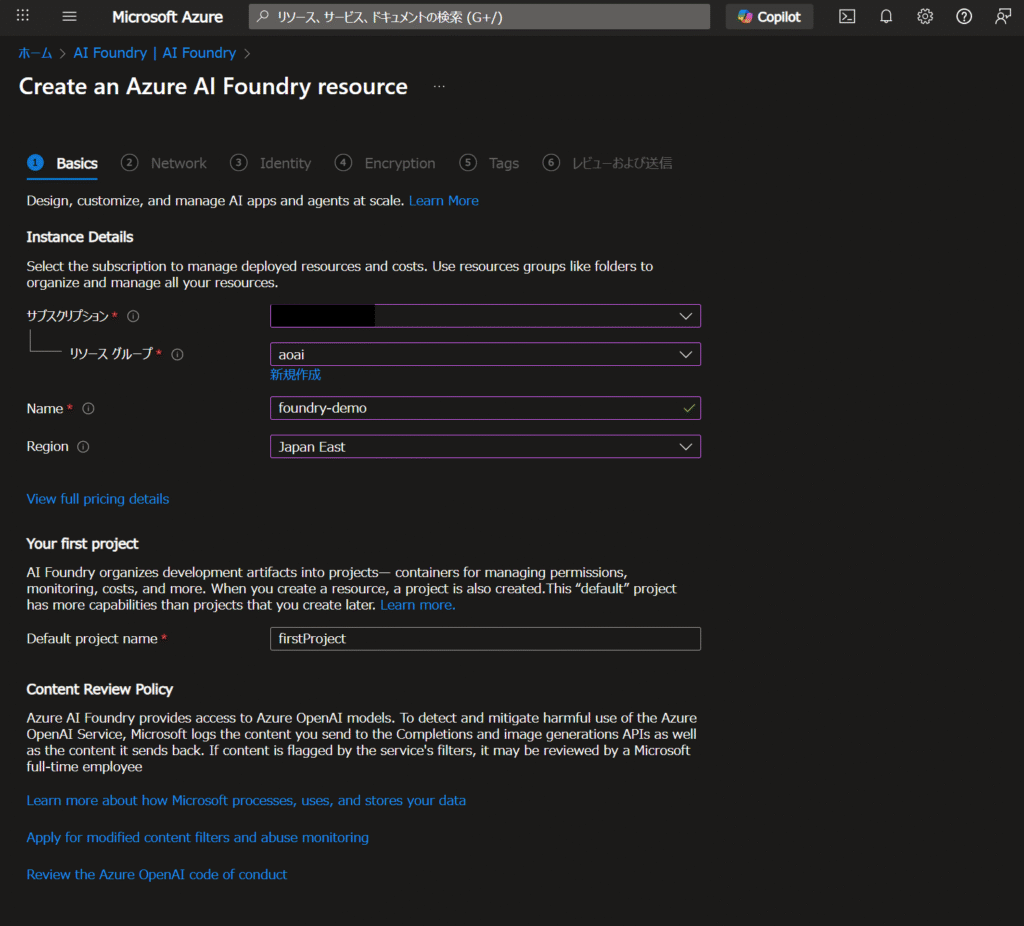

AI Foundry 自体はAzure Portalから他のAzureリソースと同様に構築可能です。なお、AI Foundryでは、HubベースのプロジェクトとFoundryプロジェクトの2種類が現在サポートされていますが、今回はFoundry Agent Serviceを利用するため、Foundryプロジェクト前提で解説します。

公式ドキュメントにも基本的にFoundryプロジェクト利用を最初に検討すると案内されています。HuggingFaceのモデルやPrompt Flowの利用等が必要な場合は、Hubベースのプロジェクトを検討すると良いでしょう。

モデルカタログ

Azure AI Foundryのモデルカタログは、単なるAzure OpenAI Serviceへの入り口ではありません。Microsoft独自のPhiシリーズ、MetaのLlama、Mistral、Cohere、DeepSeek、xAIのGrokといった最先端モデルから、Hugging Faceのコミュニティモデルまで、1,900種類を超える膨大なモデルへのアクセスを提供します 。さらに、動画生成のSora、画像生成のStable Diffusion、コード生成に特化したcodex-miniなど、特定のタスクやモダリティに特化したモデルも網羅しており、あらゆるニーズに対応可能です。

膨大な選択肢の中から最適なモデルを選ぶために、Foundryは強力なツールを提供します。

- プレイグラウンド: チャットや動画生成などのインタラクティブな環境で、プロンプトに対するモデルの挙動を直接試し、性能を体感できます 。

- リーダーボード: 品質、コスト、スループットといった客観的な基準でモデルを比較し、タスクの要件に合った候補を絞り込めます 。

- ベンチマーキング: 最も重要な機能として、自社のデータセットを使ってモデルをテストできます。これにより、一般的なベンチマークではわからない、特定のユースケースにおける実世界での性能を正確に評価できます 。

また、モデルのデプロイオプションもいくつかの選択肢を提供しています。

- Standard Deployment (Foundry/AI Servicesリソースへのデプロイ): 最も推奨され、機能が豊富なオプションです。リージョン、データゾーン、グローバルといったデータ処理の場所を選択でき、課金モデルもトークン単位の従量課金制(Pay-As-You-Go)と、大規模利用で予測可能なコストを実現するプロビジョニング済みスループットユニット(PTU)から選択できます 。主要なフラッグシップモデルはこのデプロイ方式をサポートしています。

- Serverless API Endpoint: インフラ管理やクォータ確保が不要な、完全な従量課金制モデルです。Azureがインフラを完全に管理するため、開発者はトークンあたりのコストだけで利用を開始できます。変動の激しいワークロードや、迅速なプロトタイピングに最適です 。

- Managed Compute: オープンソースモデルやカスタムモデルを、自社のサブスクリプション内の専用仮想マシン(VM)インフラにデプロイする方式です。VMの稼働時間に対して課金され、コンピューティングクォータの管理が必要になります。この方式は、インフラに対する最大限の制御を可能にし、特定のセキュリティ要件を満たすためや、Hugging Faceなどの特定のモデルコレクションを実行するために必要となります。

これらのデプロイオプションは、単なる技術的な選択肢以上の意味を持ちます。これは、管理、コスト、利便性の間の戦略的なトレードオフを組織が選択できるようにするものです。例えば、迅速な市場投入を最優先するスタートアップはServerless APIを選び、予測可能なパフォーマンスとコストを求めるミッションクリティカルなアプリケーションを持つ大企業はStandard Deployment with PTUsを選択するでしょう。そして、最高の制御とセキュリティを求める金融機関などはManaged Computeを選ぶかもしれません。

| 最適なユースケース | 課金モデル | インフラ制御 | クォータ管理 | |

| Standard Deployment | ミッションクリティカルな本番アプリ、予測可能な高負荷 | PAYG (トークン単位) または PTU (予約容量) | 中 (Azureによる管理) | 必要 (PTUの場合) |

| Serverless API | プロトタイピング、変動の激しいワークロード、迅速な開発 | PAYG (トークン単位) | 低 (Azureによる完全管理) | 不要 |

| Managed Compute | カスタムモデル、厳格なセキュリティ要件、インフラの完全制御 | コンピューティング時間単位 | 高 (自社サブスクリプション内のVM) | 必要 (VMコア) |

Content Safety

AI FoundryはMicrosoftの責任あるAI基準に準拠しており、それをサポートする機能もすべて組み込みで提供されています。例えば「デプロイの前後にエージェントの品質、安全性、セキュリティのリスクを検出する」「セキュリティ リスク、望ましくない出力、安全でないアクションから、モデル出力レベルとエージェント ランタイム レベルの両方で保護する」「トレースおよび監視ツールとコンプライアンス統合を通じてエージェントを管理する」といったプラクティスがあります。また、AIが有害なコンテンツを生成しないかどうかを検出するサービスとしてAzure AI Content Safetyがあります。

提供している主な機能は以下です。

- テキストコンテンツ:

- テキストモデレーション: テキストをスキャンし、不適切な内容を分類・識別します。

- 接地検出: AIの応答が信頼できる情報源に基づいているかを確認し、信頼性と精度を向上させます。

- 保護された素材検出: 歌詞や記事などの著作権で保護されたテキストを識別し、無断使用を防ぎます。

- コードの保護されたマテリアル検出: 公開リポジトリのコードと一致するコードセグメントを検出し、不正な複製を防ぎます。

- プロンプトシールド: AIを操作して安全プロトコルを回避しようとする「ジェイルブレイク攻撃」や、ドキュメント内に悪意のあるプロンプトを埋め込む「間接攻撃」から保護します。

- 画像コンテンツ:

- 画像コンテンツのモデレート: 不適切または有害な画像をフィルタリング・評価します。

- マルチモーダルコンテンツのモデレート: テキストと画像の組み合わせを評価し、全体的なリスクを判断します。

- カスタムフィルタリング:

- カスタムカテゴリ: ユーザーが独自のカテゴリを定義し、コンテンツをフィルタリングできます。

- 安全システムメッセージ: AIに特定の動作や制限を指示し、安全性を強化します。

また、それぞれのHarmカテゴリも存在し、「ヘイトと公平性」「性的」「暴力」「自傷行為」のカテゴリで、「安全」「低」「中」「高」というレベルで検出がされます。Content Safetyはこれ単体でもAPIとして提供されているため、様々なサービスに組み込むことが可能です。なお、AI FoundryモデルにはこのContent Safetyを利用したコンテンツフィルタリングが既定で有効になっています。

Foundryは、AIアプリケーションの「ブラックボックス」問題を解決し、「ガラスボックス」のような透明性を提供します 。Azure MonitorやApplication Insightsとの統合により、パフォーマンス、使用状況、品質に関するログ、トレース、メトリクスをリソースレベルとプロジェクトレベルの両方で収集・分析できます。

さらに、Microsoft Purviewのようなガバナンスプラットフォームとの連携により、コンプライアンス遵守や監査対応も容易になり、エンタープライズとしての信頼性を確固たるものにします 。AIを正しく安全に利用していくうえで極めて重要な「責任あるAI」のプラクティスを意識しなくても組み込まれているのがAI Foundryです。ぜひこれらの仕組みを活用してAIエージェントを作ってみてください。

まとめ

AIの試作は容易ですが、本格運用には拡張性やセキュリティといった「本番の壁」が存在します。この課題を解決するのが、AI開発の全工程を支援する統合プラットフォーム「Azure AI Foundry」ということを解説しました。次回は実際にAIエージェントを作成するPartになります。

以上、最後までご愛読いただき

ありがとうございました。

お問い合わせは、

以下のフォームへご連絡ください。