2026年初頭の Azure AI Foundry モデル事情まとめ

2026.02.03

目次

はじめに

MS開発部の松坂です。Azure AI Foundry では、Microsoft 提供モデルからサードパーティ製モデルまで、多数の LLM を簡単に利用できます。

一方で、

- 利用データが モデル学習に使われるのか

- 社内データを入力して問題ないモデルはどれか

- そもそも どのモデルが日本で使えるのか

本記事では2026 年初頭時点の情報をもとに、

Azure AI Foundry のモデルを 「学習されないと明記されているもの」と「そうでないもの」 に分けて整理します。

1. 最重要ポイント:学習されないことが保証されるモデルは限られる

Azure AI Foundry では、多数の LLM を簡単に利用できますが、社内データがモデル学習に使われないことが保証されているモデルはごく一部です。ここを理解していないと、業務データを投入した際に意図せず学習に利用されるリスクがあります。1-1. Direct Model

- Microsoft が Azure 上で直接ホスト・管理

- 他の顧客やモデル提供者と共有されない

- 代表例

- Azure OpenAI 系 GPT-4 / GPT-3.5

安全性の観点から、社内業務用途では最も安心できる選択肢です。1-2. Direct Model ではないが学習されないモデル

- Phi-4(Microsoft 提供)

- Direct Model ではありませんが、社内利用時のデータは基盤モデル学習に使われないことが保証されています

- 実務での利用において、学習されないモデルの例として整理可能

- サードパーティモデルなど

- 社内データ投入時は注意が必要

- データ取り扱いの最終的な判断はモデル提供者規約に依存

- 代表例:Grok(xAI)、Claude(Anthropic、日本リージョンでは利用不可)、DeepSeek、Kimi、LLaMA

重要:「学習されるとは書かれていない」=「学習されない」ではないことに注意してください。

2. サードパーティモデルの注意点

Azure AI Foundry では、以下のサードパーティモデルも利用可能です。ただし、これらは学習されないことの明記は Foundry 側にはないため、業務利用の際には慎重な判断が必要です。ただし、これらについて

「学習されない」との明記は Foundry 側にはありません。

| モデル | 提供元 | 備考 |

|---|---|---|

| Claude | Anthropic | 日本リージョンでは利用不可 |

| Grok | xAI | 利用には事前申請が必要 |

| DeepSeek | DeepSeek | 利用可能 |

| Kimi | Moonshot AI | 利用可能 |

| LLaMA | Meta | 一時的なクォーターを確保しつつ利用可能 |

- 最終的なデータ取り扱いポリシーは

モデル提供者側の規約に依存 - Azure 側で一律に保証されているわけではない

- 監査・法務・情報セキュリティの観点では、個別確認や PoC 限定利用が推奨される

3. 利用可否・制限まとめ(2026年初頭)

| モデル | カテゴリ | 利用可否・備考 |

|---|---|---|

| GPT-5 / GPT-4 | Direct Model | 社内利用可、安全 |

| Phi-4 | 非 Direct Model | 社内利用可、学習されないこと保証 |

| Grok | 非 Direct Model | 利用可だが申請・承認制 |

| Claude | 非 Direct Model | 日本リージョンでは利用不可 |

| DeepSeek / Kimi / LLaMA | 非 Direct Model | 利用可だがデータ投入に注意 |

4. 料金感(2026 年初頭・公式情報ベース)

Azure AI Foundry では、モデルごとにトークン単価が公式に公開されており、用途に応じたコスト戦略が立てられます。※すべて 1,000 トークンあたりの料金 に換算しています。

| モデル | 入力 | 出力 |

|---|---|---|

| GPT-5.1 | $0.00125 | $0.01 |

| Phi-4 128K | $0.000125 | $0.0005 |

| Grok-3 | $0.003 | $0.015 |

| DeepSeek V3.2 | $0.00058 | $0.00168 |

| LLaMA 3.3 70B | $0.000781 | $0.000781 |

- GPT 系

- 高精度・高推論力モデル。1,000 トークンあたりではそこまで桁違いではないが、大量生成や長文処理ではコストが効く。

- 専門性や精度を重視するタスクに最適。

- Phi-4

- 1,000 トークンあたりわずか $0.000125〜$0.0005。

- 学習されない保証があるため、業務データの安全性 × 低コストの両立が可能。

- サードパーティモデル(Grok / DeepSeek / LLaMA):学習されないとは明記されていない

- 出力トークンの単価がモデルごとに異なる。

- コストメリットはあるが、学習ポリシーを確認する必要あり。

正確な金額は以下公式サイトで確認してください。

https://azure.microsoft.com/ja-jp/pricing/details/ai-foundry-models/aoai/

5. 余談:昔は GPT 以外使うのが大変だった

数年前までは、GPT 系以外のモデルを使う場合、- GPU VM を立てる

- ドライバ・CUDA・ライブラリ調整

- スケーリングや障害対応を自前で実施

PoC でもそれなりのコストと労力がかかっていました。

現在は Azure AI Foundry により、

- API ベース

- 従量課金

- モデル切り替え容易

この点は素直に「かなり楽になった」と言えます。

6. まとめ

- 学習されないことが Microsoft により明記されているのは Direct Model とPhi

- Phi-4 は社内・業務利用における安全な選択肢

- サードパーティモデルは

- 機能面では魅力的

- ただしデータ投入には慎重な判断が必要

「何でも安全に使える」わけではない点は意識しておく必要があります。

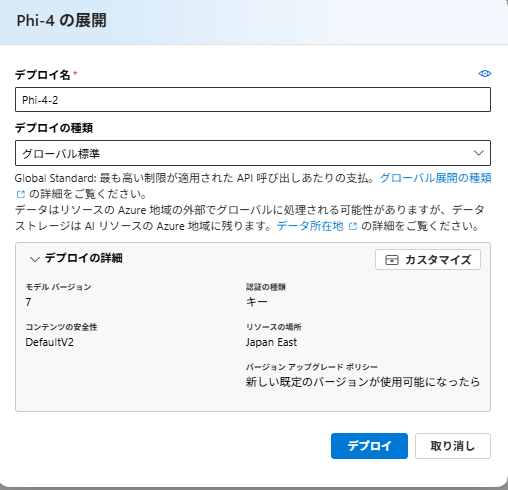

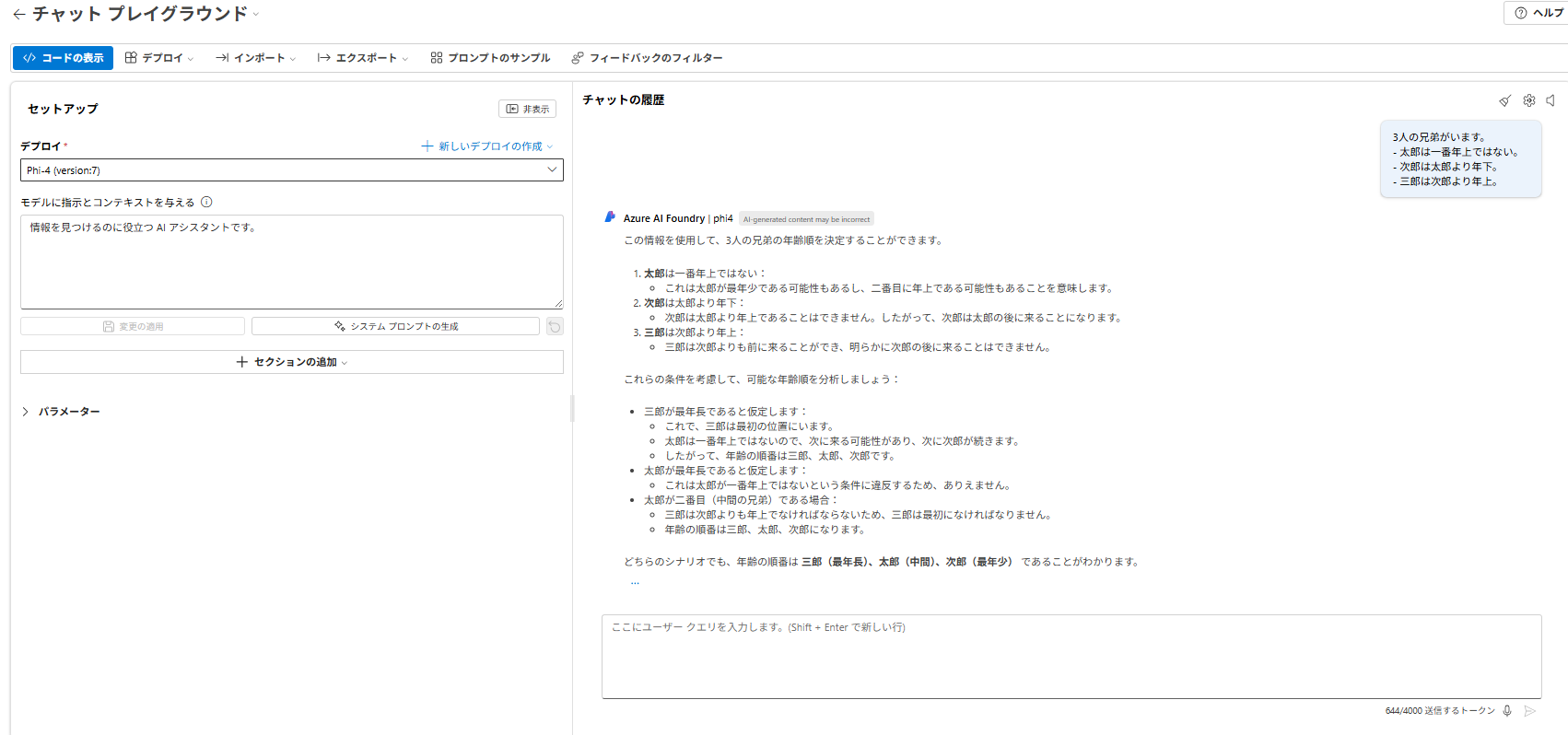

7. (おまけ)実際に Phi-4 をビルドしてみた

最後に、Azure AI Foundry 上の Phi-4 に関して情報をまとめます。Azure AI FoundryのモデルページからPhi-4を選択して

Phi-4の展開ページでデプロイを押下するだけです。

これでAzure AI FoundryからPhi-4を確認することができます。

以前はVMを立ててコストを気にしていましたが、試すだけならずいぶん気軽にできるようになったと感じてます。

補足

本記事は2026年初頭時点の情報に基づいています。最新情報は必ず公式ドキュメントをご確認ください。

以上、最後までご愛読いただき

ありがとうございました。

お問い合わせは、

以下のフォームへご連絡ください。