Azure AI FoundryのDeepResearchを使ってみたレビュー

2025.07.28

はじめに

MS開発部の松坂です。2025年夏、Azure AI Foundryに統合されたDeepResearchツールを実際に試してみました。Web最新情報の自動収集と詳細レポート生成を一気通貫で実現できると話題になっております。

本記事では、その実態・技術構成・体験談・現状の制約の情報をまとめます。

DeepResearchの概要

DeepResearchはWebベースのリサーチ自動化AIで、Bing Searchによるネット検索と、多段階のリサーチ・推論をLLMで繰り返して詳細な報告を生成します。主に O3-deep-researchモデル(Bing検索+推論+要約処理)と、GPT-4o(またはGPT-4.1など)(最終回答生成)を組み合わせて動作します。

現状の制約と技術構成

利用方法と制限

現時点ではPython SDK経由のみ正式サポート。C#やREST APIなど他言語環境から直接DeepResearchツールを叩くことはできませんが、「Pythonで構築したエージェント」をラップする形でC#、REST APIなどから呼び出すことは技術的に可能です。

Azure AI FoundryポータルUIから直接DeepResearchエージェントを管理・利用することは不可となっています。

| 利用手段 | DeepResearchサポート |

|---|---|

| Python SDK | 〇 |

| C# SDK | 〇(エージェント構築前提) |

| REST API | 〇(エージェント構築前提) |

| Foundryポータル | × |

- 「O3-deep-research」:Bing検索+情報収集・要約

- 「GPT-4o」(もしくは「GPT-4.1」等):最終生成&出力用

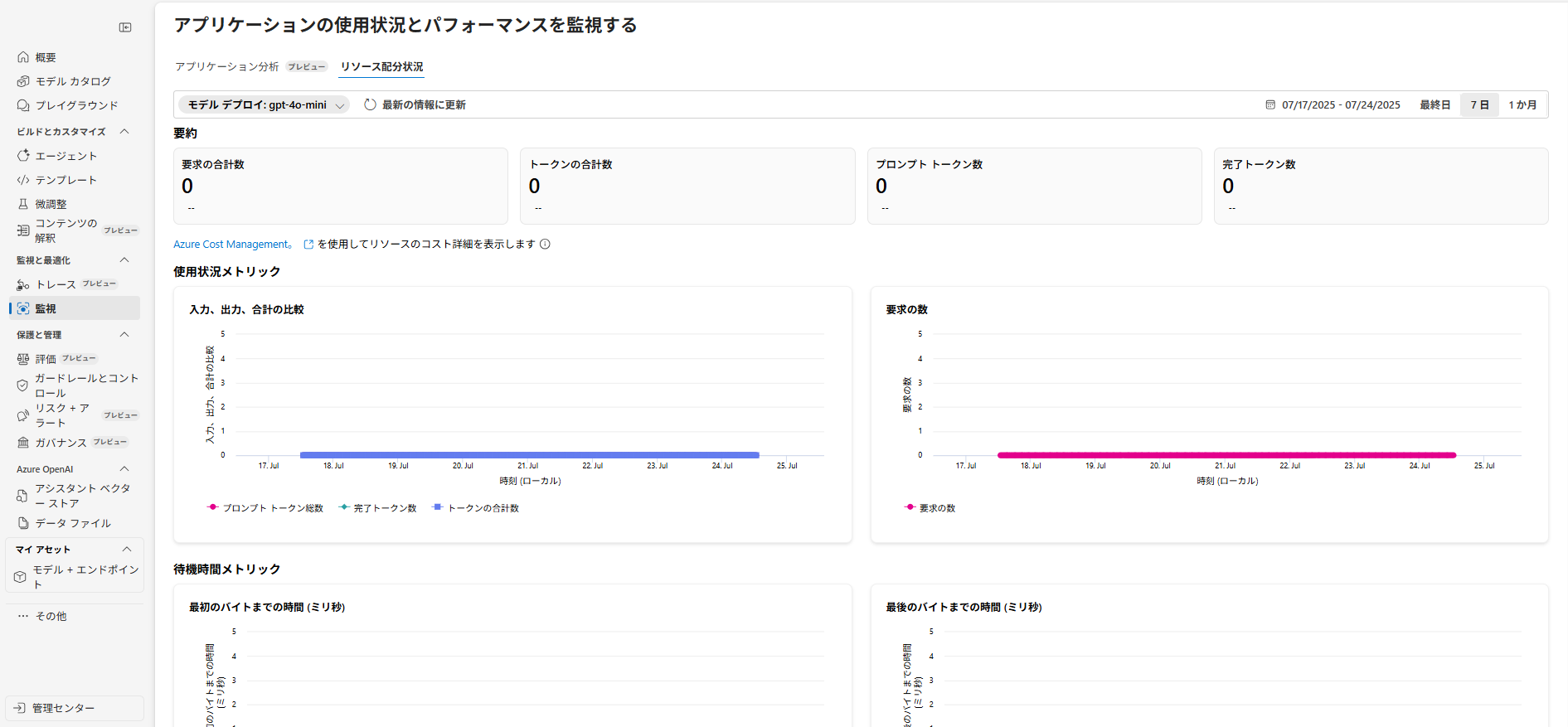

モニタリング・トークン情報

トークン消費/利用状況の可視化は、GPT-4oなどの出力用モデルのみです。O3-deep-researchのトークン情報はAzure AI Foundryの専用監視画面からしか参照できません。用途や管理の切り分けには注意が必要です。

基本的な設定やトークン監視は下記に要約します:

| モデル | トークン確認場所 |

|---|---|

| O3-deep-research | Azure AI Foundry監視画面のみ |

| GPT-4o/4.1 | アウトプットの情報やスレッド情報などから確認できる |

運用上の注意点・未記載事項

O3-deep-researchモデルは対応リージョンが限られています(2025年7月時点:West US、Norway East)。DeepResearchはまだプレビュー段階と見られ、価格情報は公式にも未記載です。正式サービス化までは仕様や課金体系が流動的な可能性があります。

実行例・体験談

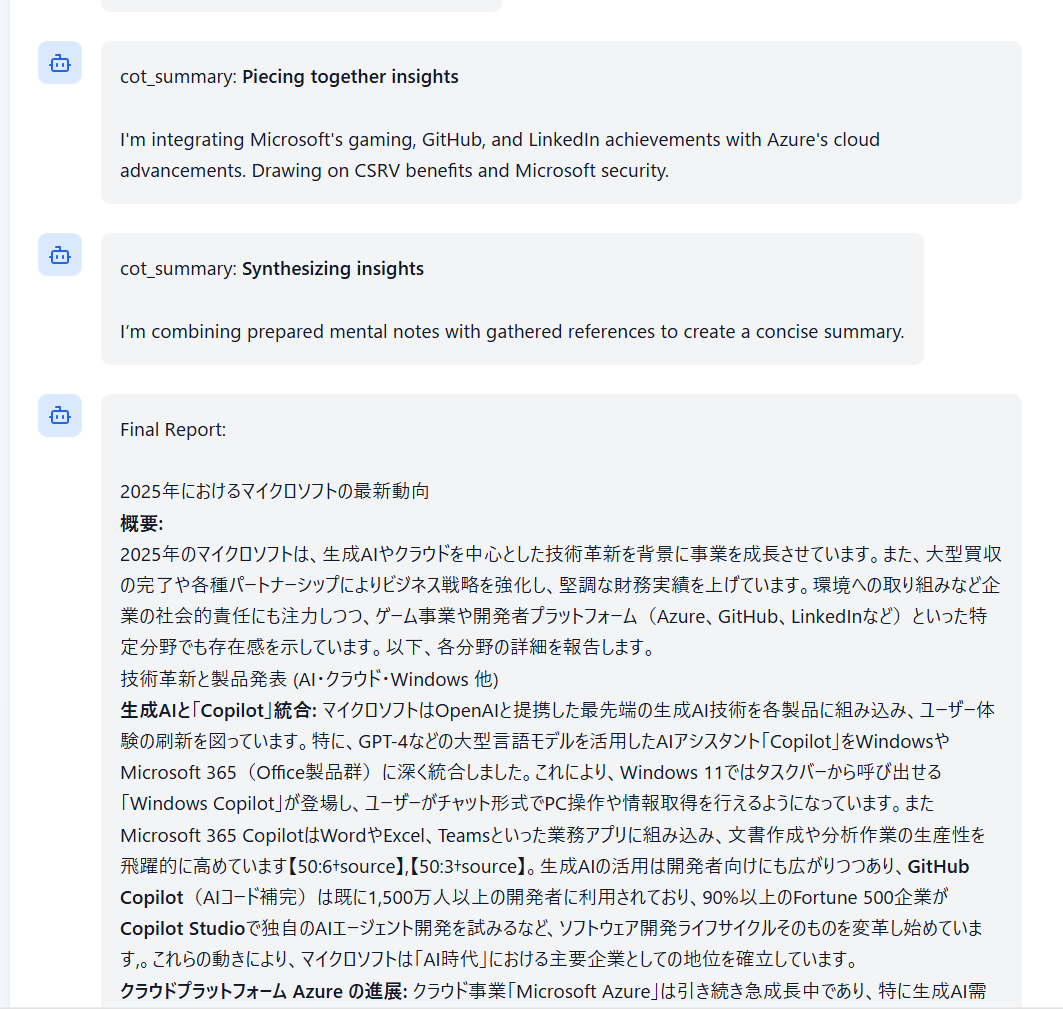

試した範囲では「10分程度」と比較的長時間・大規模な検索と考察が自動で行われるのを確認できました。質問内容によっては応答時間の前後は発生すると思われます。こちらの図ではDeepResearchを使用した際の画面を作成しました。質問してからエージェントがBingで繰り返し検索している様子が確認できます。

複数回Bing検索を行いに最終的な回答を表示してくれました。

複数回Bing検索を行いに最終的な回答を表示してくれました。 今回の例では、以下のようなトークン消費が確認されました:

今回の例では、以下のようなトークン消費が確認されました:- O3-deepresearch入力トークン:1,452,400

- O3-deepresearch出力トークン:30,400

- GPT-4o入力トークン:3,823

- GPT-4o出力トークン:355

まとめ

DeepResearchは、現時点でも「Python SDK経由でのフル自動リサーチ」「ネットの最新情報をふまえたレポート生成」などAI活用を加速する強力なツールです。一方、「プレビュー段階」「UI未対応」「トークン・監視限定」「価格未定」など制約もあるため実運用ではPoCや限定的な用途から始めるのが無難でしょう。

最新動向や公開情報を常時キャッチアップしつつ、プロダクション投入を検討していきましょう。

以上、最後までご愛読いただき

ありがとうございました。

お問い合わせは、

以下のフォームへご連絡ください。